Intelligent Data Warehousing su Databricks

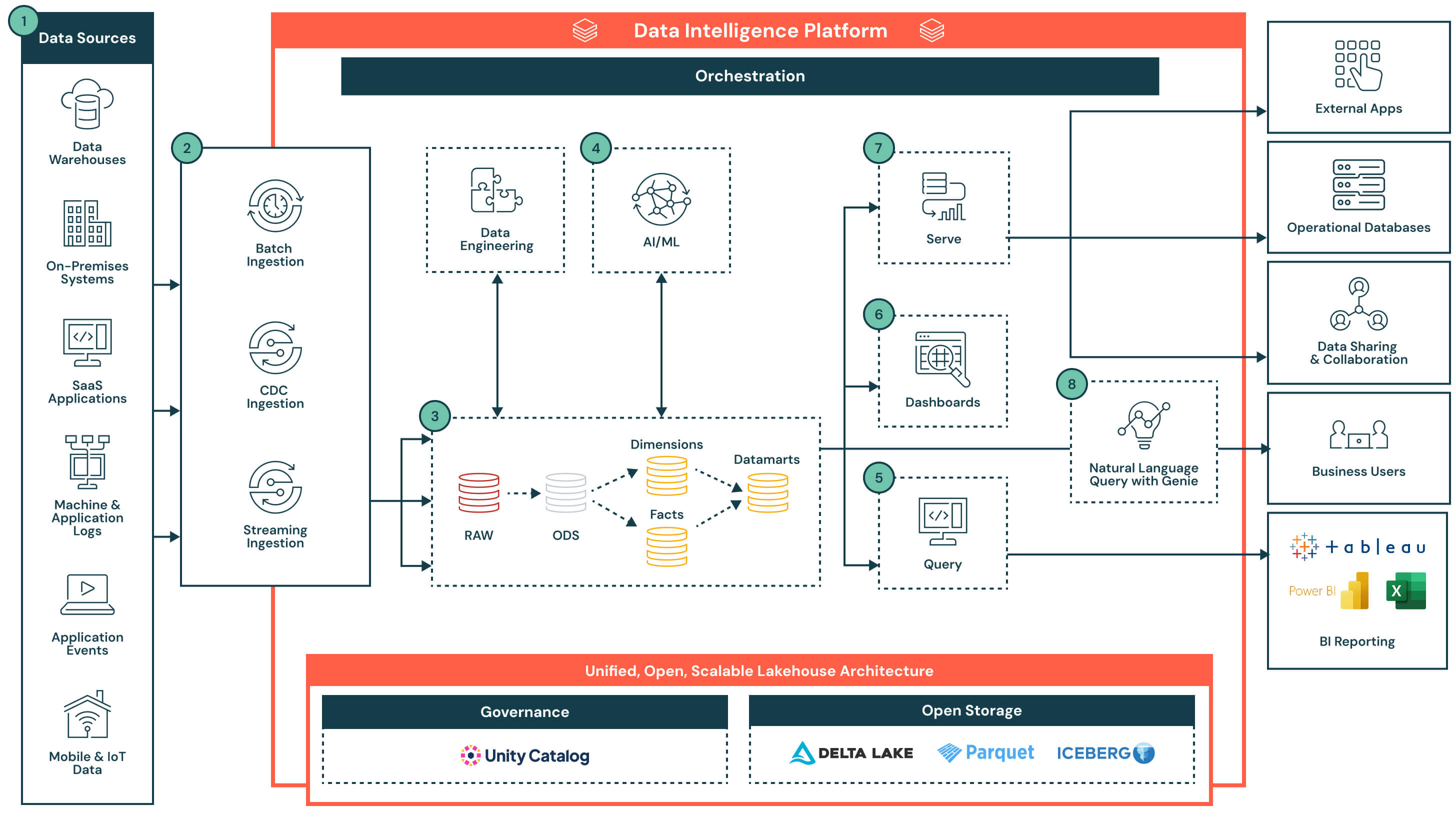

Questa architettura mostra come la Piattaforma Data Intelligence di Databricks abilita il moderno data warehousing e BI combinando ingestione streaming e batch, storage governato, analisi SQL scalabile e IA integrata su un lakehouse unificato.

Riassunto dell'architettura

L'architettura supporta la reportistica tradizionale, i cruscotti in tempo reale, la modellazione predittiva e l'analisi self-service - il tutto rispettando gli standard aziendali per la sicurezza, la governance e le prestazioni.

Questa soluzione dimostra come la Piattaforma di Intelligenza dei Dati Databricks, alimentata da Databricks SQL, aiuti le organizzazioni a modernizzare la loro strategia di data warehousing, soddisfacendo le esigenze sia dei team di dati che degli stakeholder aziendali.

L'architettura inizia con un lakehouse aperto e governato gestito da Unity Catalog. I dati vengono acquisiti da una serie di sistemi, tra cui database operativi, app SaaS, flussi di eventi e sistemi di file, e vengono depositati in uno strato di archiviazione centrale. L'intelligenza dei dati della piattaforma alimenta tutto, dall'ETL e analisi SQL a dashboard e casi d'uso di AI. Supportando l'accesso flessibile attraverso SQL, strumenti BI e interrogazioni in linguaggio naturale, la piattaforma accelera la consegna del prodotto dati e rende accessibili le intuizioni in tutta l'organizzazione.

Casi d'uso

Casi Tecnici di Utilizzo

- Ingestione di dati strutturati, non strutturati, batch e streaming da diverse fonti

- Costruzione di robusti pipeline ETL dichiarativi

- Modellazione di fatti, dimensioni e data marts utilizzando un'architettura a medaglione

- Esecuzione di query SQL ad alta concorrenza per la reportistica e il dashboarding

- Integrazione degli output ML direttamente nel magazzino per l'uso a valle

Casi d'uso aziendali

- Fornire cruscotti in tempo reale su vendite, operazioni o metriche dei clienti

- Abilitazione dell'esplorazione ad hoc attraverso interfacce di linguaggio naturale come Genie

- Supporto di casi d'uso predittivi come la previsione della domanda e la modellazione del churn

- Condivisione di prodotti dati governati tra i dipartimenti o con i partner

- Fornitura di intuizioni rapide e affidabili per i team di finanza, marketing e prodotto

Capacità chiave con Data Intelligence

Il componente di intelligenza dei dati di questa architettura rende la piattaforma più intelligente, più adattiva e più facile da utilizzare per le persone e i carichi di lavoro. Applica l'IA e la consapevolezza dei metadati in tutto il sistema per semplificare le esperienze e automatizzare il processo decisionale:

- Interfaccia di linguaggio naturale (Genie): Comprende il contesto aziendale e permette agli utenti di fare domande sui dati in linguaggio semplice

- Consapevolezza semantica: Riconosce le relazioni tra tabelle, colonne e schemi di utilizzo per suggerire join, filtri o calcoli

- Ottimizzazione predittiva: Adeguamento continuo delle prestazioni delle query e dell'allocazione di calcolo in base ai carichi di lavoro storici

- Governance unificata: Etichetta, classifica e traccia l'uso degli asset di dati, rendendo la scoperta più intuitiva e sicura

- Capacità chiave: Una piattaforma auto-ottimizzante che si adatta ai tuoi dati e utenti

- Differenziatore: L'intelligenza dei dati è incorporata in tutto il processo di ingestione, query, governance e visualizzazione - non è aggiunta in seguito

Flusso di dati con capacità chiave e differenziatori

- Fonti di dati: I dati sono memorizzati in una vasta gamma di sistemi, tra cui applicazioni aziendali (ad es., SAP, Salesforce), database, dispositivi IoT, log di applicazioni e API esterne. Queste fonti possono produrre dati strutturati, semi-strutturati o non strutturati.

- Ingestione dei dati: Porta i dati attraverso lavori batch, cattura dei dati di modifica (CDC) o streaming. Questi pipeline alimentano l'architettura del lakehouse in tempo quasi reale o a intervalli programmati, a seconda del sistema sorgente e del caso d'uso.

- Differenziatore chiave: Ingestione unificata per tutte le modalità - batch, streaming e CDC - senza la necessità di infrastrutture o pipeline separate

- Trasformazione dei dati, ETL, Pipeline dichiarativi: Una volta ingeriti, i dati vengono trasformati attraverso l'architettura a medaglione e progressivamente raffinati da dati grezzi a dati curati.

- Zona Raw a Zona Bronze: Dati ingeriti da sistemi sorgenti esterni dove le strutture in questo strato corrispondono alle strutture delle tabelle del sistema sorgente "così come sono", senza trasformazioni o aggiornamenti dei dati

- Dalla zona Bronzo alla zona Argento: Standardizza e pulisci i dati in arrivo

- Zona Silver a Zona Gold: Applicare la logica aziendale per creare modelli riutilizzabili

- Fatti e dimensioni → data marts: Aggregare e curare i dati per l'analisi a valle

- Differenziatore chiave: Pipeline dichiarativi di produzione con linea di discendenza incorporata, osservabilità e evoluzione dello schema

- Dati curati per casi d'uso di AI: I dati curati dai data mart possono essere utilizzati per addestrare o applicare modelli di apprendimento automatico. Questi modelli supportano casi d'uso come la previsione della domanda, il rilevamento di anomalie e il punteggio dei clienti.

- Le uscite dei modelli vengono memorizzate insieme ai dati del magazzino tradizionale per un facile accesso tramite SQL o dashboard

- I risultati possono essere aggiornati su un programma o valutati in tempo reale, a seconda dei requisiti

- Differenziatore chiave: Analisi e carichi di lavoro AI collocati sulla stessa piattaforma - non è necessario spostare i dati. Gli output del modello sono trattati come asset governati e interrogabili nativi.

- Strumenti di reporting BI alimentati da query: Databricks SQL supporta l'interrogazione ad alta concorrenza e a bassa latenza attraverso il calcolo serverless, e si collega facilmente agli strumenti BI più popolari.

- Editor di query integrato e cronologia delle query

- Le query restituiscono risultati governati e aggiornati dai data marts o dagli output del modello arricchiti

- Differenziatore chiave: Databricks SQL consente agli strumenti BI di interrogare direttamente i dati, senza replicazione, riducendo la complessità, evitando costi di licenza aggiuntivi e abbassando il TCO complessivo. Combinato con il calcolo serverless e l'ottimizzazione intelligente, offre prestazioni di livello di magazzino con una minima messa a punto.

- Dashboard: Possono essere costruite direttamente in Databricks o in strumenti BI esterni come Power BI o Tableau. Gli utenti possono descrivere i visual in linguaggio naturale, e l'Assistente Databricks genererà i grafici corrispondenti, che possono poi essere perfezionati utilizzando un'interfaccia point-and-click.

- Creazione di visualizzazioni utilizzando input di linguaggio naturale

- Modifica ed esplorazione interattiva dei cruscotti con filtri e drill-down

- Pubblicazione e condivisione sicura dei cruscotti in tutta l'organizzazione, incluso con utenti al di fuori dello spazio di lavoro Databricks

- Differenziatore chiave: Offre un'esperienza di costruzione e esplorazione dei cruscotti a basso codice e assistita dall'IA su dati governati e in tempo reale

- Servizio di dati curati: Una volta raffinati, i dati possono essere serviti oltre i cruscotti:

- Condivisi con applicazioni a valle o database operativi per la decisione transazionale

- Utilizzato in quaderni collaborativi per l'analisi

- Distribuiti tramite Delta Sharing a partner, team o consumatori esterni con governance unificata

- Interrogazione in linguaggio naturale (NLQ): Gli utenti business possono accedere ai dati governati utilizzando il linguaggio naturale. Questa esperienza conversazionale, alimentata da AI generativa, consente ai team di andare oltre le dashboard statiche e ottenere intuizioni self-service in tempo reale. NLQ traduce l'intento dell'utente in SQL sfruttando la semantica e i metadati dell'organizzazione da Unity Catalog.

- Supporta domande ad hoc, interattive, in tempo reale che non sono predefinite nei cruscotti

- Si adatta intelligentemente all'evoluzione della terminologia e del contesto aziendale nel tempo

- Sfrutta i controlli di governance e accesso ai dati esistenti tramite Unity Catalog

- Fornisce auditabilità e tracciabilità delle query in linguaggio naturale per la conformità e la trasparenza

- Differenziatore chiave: Si adatta continuamente ai concetti aziendali in evoluzione, fornendo risposte accurate e consapevoli del contesto senza richiedere competenze SQL

- Capacità della piattaforma: Governance, performance, orchestrazione e storage aperto: L'architettura è sostenuta da un insieme di capacità native della piattaforma che supportano la sicurezza, l'ottimizzazione, l'automazione e l'interoperabilità in tutto il ciclo di vita dei dati. Capacità chiave:

- Governance: Unity Catalog fornisce controllo di accesso centralizzato, linea di discendenza, auditing e classificazione dei dati su tutti i carichi di lavoro

- Prestazioni: Il motore Photon, la memorizzazione intelligente nella cache e l'ottimizzazione consapevole del carico di lavoro forniscono query veloci senza necessità di regolazione manuale

- Orchestrazione: L'orchestrazione integrata gestisce i pipeline di dati, i flussi di lavoro AI e i lavori programmati su carichi di lavoro batch e streaming, con supporto nativo per la gestione delle dipendenze e la gestione degli errori

- Archiviazione aperta: I dati sono memorizzati in formati aperti (Delta Lake, Parquet, Iceberg), consentendo l'interoperabilità tra gli strumenti, la portabilità tra le piattaforme e la durata a lungo termine senza il blocco del fornitore

- Monitoraggio e auditabilità: Visibilità end-to-end sulle prestazioni delle query, l'esecuzione dei pipeline e l'accesso degli utenti per un migliore controllo e gestione dei costi

- Differenziatore chiave: I servizi a livello di piattaforma sono integrati, non stratificati, garantendo che la governance, l'automazione e le prestazioni siano coerenti in tutti i flussi di lavoro dei dati, le nuvole e i team