Entrepôt de données intelligent sur Databricks

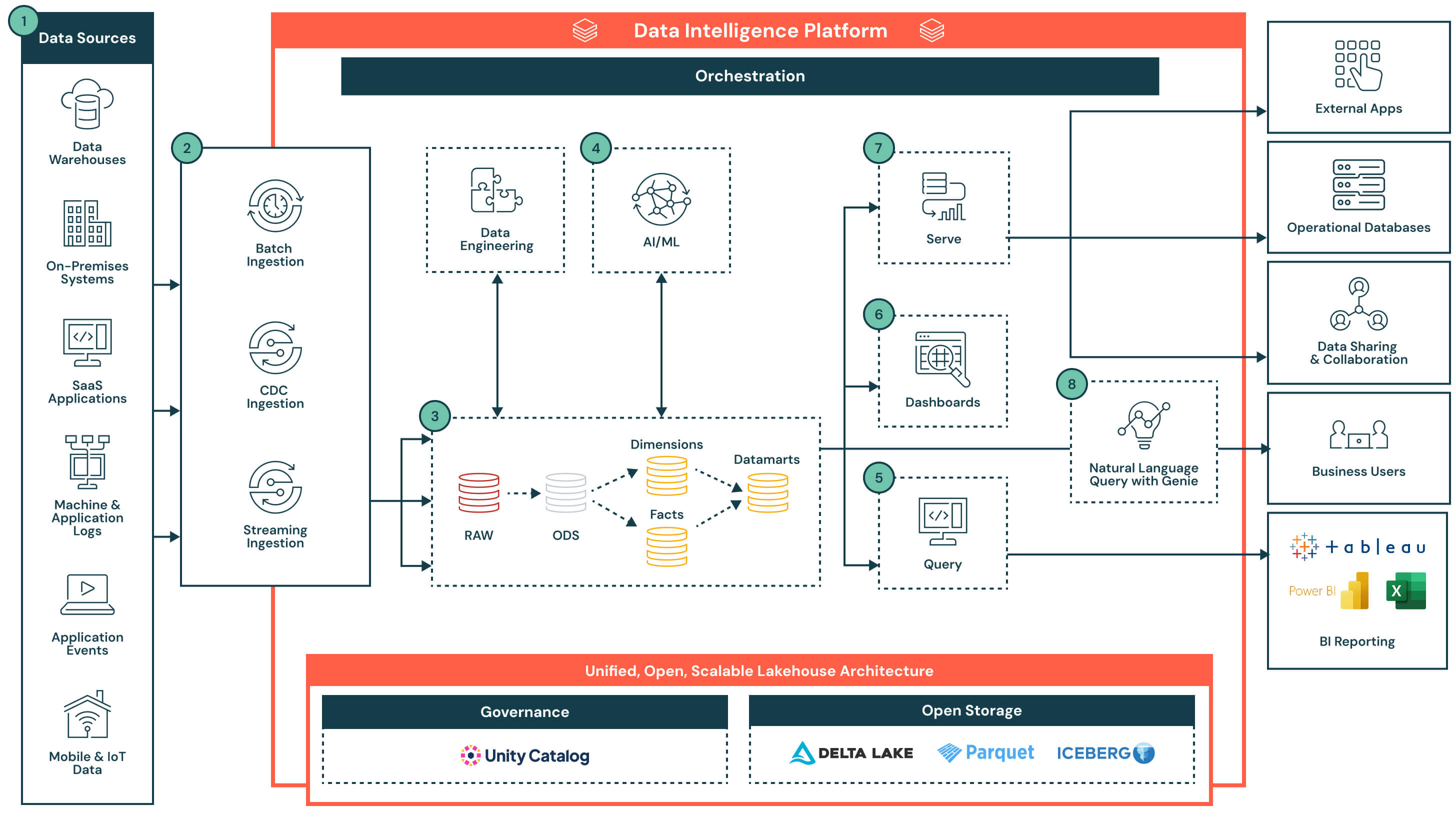

Cette architecture montre comment la plateforme Data Intelligence de Databricks modernise l’entrepôt de données et le BI via l’ingestion en flux et par lots, le stockage gouverné, l’analyse SQL évolutive et l’IA intégrée sur un lakehouse unifié.

Résumé de l'architecture

L'architecture prend en charge les rapports traditionnels, les tableaux de bord en temps réel, la modélisation prédictive et l'analytique en libre-service - tout en respectant les normes d'entreprise en matière de sécurité, de gouvernance et de performance.

Cette solution démontre comment la plateforme d'intelligence de données Databricks, alimentée par Databricks SQL, aide les organisations à moderniser leur stratégie de stockage de données tout en répondant aux besoins des équipes de données et des parties prenantes de l'entreprise.

L'architecture commence par un lakehouse ouvert et gouverné géré par Unity Catalog. Les données sont ingérées à partir d'une gamme de systèmes - y compris les bases de données opérationnelles, les applications SaaS, les flux d'événements et les systèmes de fichiers - et atterrissent dans une couche de stockage centrale. L'intelligence de données de la plateforme alimente tout, de l'ETL et de l'analytique SQL aux tableaux de bord et aux cas d'utilisation de l'IA. En prenant en charge un accès flexible via SQL, les outils BI et les requêtes en langage naturel, la plateforme accélère la livraison de produits de données et rend les informations accessibles dans toute l'organisation.

Cas d’utilisation

Cas d’utilisation technique

- Ingestion de données structurées, non structurées, par lots et en streaming provenant de sources diverses

- Construire des pipelines ETL déclaratifs robustes

- Modélisation de faits, dimensions et data marts à l'aide d'une architecture de médaille

- Exécuter des requêtes SQL à haute concurrence pour les rapports et les tableaux de bord

- Intégrer les résultats de ML directement dans l'entrepôt pour une utilisation en aval

Cas d'utilisation commerciaux

- Fourniture de tableaux de bord en temps réel sur les ventes, les opérations ou les indicateurs clients

- Permettre l'exploration ad hoc à travers des interfaces en langage naturel comme Genie

- Soutien des cas d'utilisation prédictifs tels que la prévision de la demande et la modélisation de l'attrition

- Partage de produits de données gouvernés entre les départements ou avec des partenaires

- Fourniture d'informations rapides et fiables pour les équipes de finance, de marketing et de produit

Capacités clés avec la Data Intelligence

Le composant de data intelligence de cette architecture rend la plateforme plus intelligente, plus adaptative et plus facile à utiliser pour différentes personnes et charges de travail. Il applique l'IA et la connaissance des métadonnées à travers le système pour simplifier les expériences et automatiser la prise de décision :

- Interface en langage naturel (Genie) : Comprend le contexte commercial et permet aux utilisateurs de poser des questions sur les données en langage courant

- Conscience sémantique : Reconnaît les relations entre les tables, les colonnes et les modèles d'utilisation pour suggérer des jointures, des filtres ou des calculs

- Optimisation prédictive : Ajuste en continu les performances des requêtes et l'allocation de calcul en fonction des charges de travail historiques

- Gouvernance unifiée : Tag, classe et suit l'utilisation des actifs de données, rendant la découverte plus intuitive et sécurisée

- Capacité clé : Une plateforme auto-optimisante qui s'adapte à vos données et utilisateurs

- Différenciateur : L'intelligence des données est intégrée à travers l'ingestion, la requête, la gouvernance et la visualisation - pas ajoutée après coup

Flux de données avec capacités clés et différenciateurs

- Sources de données : Les données sont stockées dans une grande variété de systèmes, y compris les applications d'entreprise (par exemple, SAP, Salesforce), les bases de données, les appareils IoT, les journaux d'application et les API externes. Ces sources peuvent produire des données structurées, semi-structurées ou non structurées.

- Ingestion de données : Intègre les données par le biais de travaux par lots, de la capture de données modifiées (CDC) ou du streaming. Ces pipelines alimentent l'architecture du lakehouse en temps quasi réel ou à des intervalles programmés, en fonction du système source et du cas d'utilisation.

- Différenciateur clé : Ingestion unifiée pour toutes les modalités - batch, streaming et CDC - sans nécessiter d'infrastructure ou de pipelines séparés

- Transformation des données, ETL, Pipelines déclaratifs : Une fois ingérées, les données sont transformées à travers l'architecture de médaille et progressivement affinées de données brutes à données organisées.

- Zone brute à zone Bronze : Données ingérées à partir de systèmes sources externes où les structures dans cette couche correspondent aux structures de table du système source "telles quelles", sans transformation ni mise à jour des données

- Zone Bronze à Zone Argent : Standardiser et nettoyer les données entrantes

- Zone Argent à Zone Or : Appliquer la logique commerciale pour créer des modèles réutilisables

- Faits et dimensions → Data marts : Agrège et organise les données pour l'analyse en aval

- Différenciateur clé : Pipelines déclaratifs de production avec lignée intégrée, observabilité et évolution de schéma

- Données organisées pour les cas d'utilisation de l'IA : Les données organisées provenant des data marts peuvent être utilisées pour former ou appliquer des modèles d'apprentissage automatique. Ces modèles soutiennent des cas d'utilisation tels que la prévision de la demande, la détection d'anomalies et le scoring client.

- Les résultats des modèles sont stockés à côté des données d'entrepôt traditionnelles pour un accès facile via SQL ou des tableaux de bord

- Les résultats peuvent être mis à jour selon un calendrier ou notés en temps réel, selon les besoins

- Différenciateur clé : Analytiques et charges de travail d'IA colocalisées sur la même plateforme — aucun mouvement de données nécessaire. Les résultats des modèles sont traités comme des actifs natifs, interrogeables et gouvernés.

- Outils de reporting BI alimentés par des requêtes : Databricks SQL supporte des requêtes à haute concurrence et à faible latence grâce à un calcul sans serveur, et se connecte facilement à des outils BI populaires.

- Éditeur de requêtes intégré et historique des requêtes

- Les requêtes renvoient des résultats gouvernés et à jour provenant de data marts ou de sorties de modèles enrichies

- Différenciateur clé : Databricks SQL permet aux outils BI de requêter directement les données - sans réplication - réduisant la complexité, évitant des coûts de licence supplémentaires et réduisant le TCO global. Combiné avec le calcul sans serveur et l'optimisation intelligente, il offre des performances de niveau entrepôt avec un réglage minimal.

- Tableaux de bord : Peuvent être construits directement dans Databricks ou dans des outils BI externes comme Power BI ou Tableau. Les utilisateurs peuvent décrire les visuels en langage naturel, et l'Assistant Databricks générera les graphiques correspondants, qui peuvent ensuite être affinés à l'aide d'une interface point-and-click.

- Créer des visualisations en utilisant une entrée en langage naturel

- Modifiez et explorez les tableaux de bord de manière interactive avec des filtres et des approfondissements

- Publiez et partagez en toute sécurité les tableaux de bord à travers l'organisation, y compris avec des utilisateurs en dehors de l'espace de travail Databricks

- Différenciateur clé : Offre une expérience de construction et d'exploration de tableaux de bord sur des données gouvernées et en temps réel, assistée par l'IA et à faible code

- Servir des données organisées : Une fois affinées, les données peuvent être servies au-delà des tableaux de bord :

- Partagées avec des applications en aval ou des bases de données opérationnelles pour la prise de décision transactionnelle

- Utilisé dans des cahiers collaboratifs pour l'analyse

- Distribuées via Delta Sharing à des partenaires, équipes ou consommateurs externes avec une gouvernance unifiée

- Requête en langage naturel (NLQ) : Les utilisateurs d'entreprise peuvent accéder aux données gouvernées en utilisant le langage naturel. Cette expérience conversationnelle, alimentée par l'IA générative, permet aux équipes de dépasser les tableaux de bord statiques et d'obtenir des insights en libre-service en temps réel. NLQ traduit l'intention de l'utilisateur en SQL en exploitant la sémantique et les métadonnées de l'organisation à partir du Catalogue Unity.

- Prend en charge les questions ad hoc, interactives, en temps réel qui ne sont pas pré-intégrées dans les tableaux de bord

- S'adapte intelligemment à l'évolution de la terminologie et du contexte commercial au fil du temps

- Exploite les contrôles existants de gouvernance et d'accès aux données via Unity Catalog

- Fournit une auditabilité et une traçabilité des requêtes en langage naturel pour la conformité et la transparence

- Différenciateur clé : S'adapte continuellement aux concepts commerciaux en évolution, fournissant des réponses précises et conscientes du contexte sans nécessiter d'expertise SQL

- Capacités de la plateforme : Gouvernance, performance, orchestration et stockage ouvert : L'architecture est soutenue par un ensemble de capacités natives de la plateforme qui soutiennent la sécurité, l'optimisation, l'automatisation et l'interopérabilité à travers tout le cycle de vie des données. Capacités clés :

- Gouvernance : Le catalogue Unity offre un contrôle d'accès centralisé, une lignée, un audit et une classification des données à travers toutes les charges de travail

- Performance : Le moteur Photon, la mise en cache intelligente et l'optimisation consciente de la charge de travail fournissent des requêtes rapides sans réglage manuel

- Orchestration : L'orchestration intégrée gère les pipelines de données, les workflows d'IA et les tâches planifiées à travers les charges de travail par lots et en streaming, avec un support natif pour la gestion des dépendances et la gestion des erreurs

- Stockage ouvert : Les données sont stockées dans des formats ouverts (Delta Lake, Parquet, Iceberg), permettant l'interopérabilité entre les outils, la portabilité entre les plateformes et la durabilité à long terme sans verrouillage par le fournisseur

- Surveillance et auditabilité : Visibilité de bout en bout sur les performances des requêtes, l'exécution des pipelines et l'accès des utilisateurs pour un meilleur contrôle et une gestion des coûts

- Différenciateur clé : Les services au niveau de la plateforme sont intégrés — et non superposés — assurant une gouvernance, une automatisation et des performances cohérentes à travers tous les workflows de données, les clouds et les équipes